Los algoritmos han invadido casi todos los ámbitos de la vida: median la interacción social, facilitan tareas de gobierno, hacen negocios... Pero si bien el dominio algorítmico continúa creciendo, las formas en que operan los algoritmos permanecen ocultas a nuestra comprensión. La sociedad nota los efectos tangibles de los algoritmos, como sus externalidades negativas en forma de discriminación por raza y género, el debilitamiento de la democracia, reproducción de la desigualdad, ... pero no conocemos cómo se produjeron estos efectos. El primer paso hacia el desmantelamiento y la lucha contra esos efectos dañinos que supone este control es la creación de un amplio conocimiento sobre el funcionamiento de los algoritmos, no sólo en su capacidad convencionalmente entendida como instrumentos matemáticos, sino como sistemas socio-técnicos con múltiples consecuencias sociales.

Si queremos frenar el sesgo automatizado y las externalidades negativas de los algoritmos, debemos hacer frente a los actuales desafíos de conocer los algoritmos, reconociéndolos como sistemas opacos, complejos y contingentes que evaden el análisis simple.

Opacidad

En primer lugar, los algoritmos son difíciles de conocer porque son, a propósito, opacos. A menos que se trate de software de código abierto a través de un repositorio como Github, es casi imposible ver el funcionamiento interno de un algoritmo. Esto se debe a que la mayoría de los algoritmos son de naturaleza propietaria (Kitchin 2017). En la mayoría de las industrias de Internet -motores de búsqueda, redes sociales, servicios de recomendación, publicidad, etc.- los algoritmos constituyen la piedra angular de esos negocios. El valor y la ventaja competitiva de una empresa dependen de la eficacia y la capacidad de resolución de problemas de sus algoritmos (ibíd.). A medida que los países de todo el mundo hacen la transición a economías plenamente basadas en bases de datos, más empresas tienen el incentivo de proteger sus algoritmos como secretos comerciales, revelando detalles mínimos pero nunca divulgando al público plenamente el funcionamiento interno de sus sistemas.

Kitchin (2017) argumenta que tal opacidad crea obstáculos sustanciales para los investigadores. Lo expresa sucintamente: "el problema para la experimentación es que no somos personas de adentro" (ibid). Mientras que los "expertos" de las empresas (por ejemplo, ingenieros y ejecutivos) tienen acceso a una visión transparente y panorámica del algoritmo, los investigadores y el público no lo tienen. Solo podemos ver lo que sale, las consecuencias del algoritmo. Para solucionar este problema, los investigadores a menudo estudian algoritmos mediante ingeniería inversa, una tarea difícil y lenta en la que se deconstruye el sistema experimentando metódicamente con diferentes valores de entrada para descifrar las relaciones de los valores de salida. Desafortunadamente, incluso las tácticas como la ingeniería inversa no son suficientes para estudiar los algoritmos dada la complejidad y contingencia de estos sistemas.

Complejidad

Los algoritmos pueden ser increíblemente complejos, tanto que "Ni siquiera la gente que escribe los algoritmos sabe realmente cómo funcionan" En un artículo de The Atlantic, Andrew Moore, el decano de informática de la Universidad Carnegie Mellon y ex vicepresidente de Google, problematiza "cuánto entienden los proveedores de contenido cómo funcionan sus propios sistemas" (ibíd.). Aunque los ejecutivos e ingenieros ("insiders") puedan tener una perspectiva clara y abarcadora del código de un algoritmo, es posible que no comprendan la funcionalidad completa de sus sistemas, incluidas sus diversas y inesperadas repercusiones sociales.

Además, lo que a menudo imaginamos como un algoritmo singular es en realidad un sistema algorítmico, o un conjunto de algoritmos entrelazados que incluye "potencialmente miles de individuos, conjuntos de datos, objetos, aparatos, elementos, protocolos, normas, leyes, etc. que enmarcan su desarrollo" (Kitchin 2017). Los sistemas algorítmicos son complejos porque son heterogéneos (se ven y se comportan de manera diferente unos de otros) y están integrados con otros algoritmos (ibíd.). La apertura de un sistema algorítmico revela una desordenada estructura de retazos que recurre a "cientos de otros algoritmos" (ibíd.). Hace décadas, Foote y Yoder (1997) compararon el código con una "Gran bola de barro", o "una jungla de código de espagueti de estructura desordenada, desparramada, descuidada, con cintas de conductos y cables de rescate".

Seaver (2014) se basa en esa comparación de la programación no directa, afirmando que "los sistemas algorítmicos no son pequeñas cajas independientes, sino masivas, conectadas en red con cientos de manos llegando a ellas, retocando y afinando, intercambiando partes y experimentando con nuevos arreglos.”

Contingencia

Además de ser complejos y opacos, los algoritmos desafían a los investigadores porque son sistemas contingentes o dependientes del tiempo y el espacio y que se adaptan constantemente a los inputs contextuales que se les presentan. Dado que los algoritmos de aprendizaje automático incorporan y aprenden de los conjuntos de datos en tiempo real (cambiando a su vez su lógica interna en tiempo real), es imposible suponer que se interactúa con el mismo algoritmo dos veces (Seaver 2014). A través de la personalización, también mutan, reaccionan y se adaptan según el perfil y el comportamiento únicos de un usuario, lo que hace que el método de experimentación de un solo usuario sea obsoleto (ibid).

Seaver (2014) da un ejemplo de cómo se desarrolla esta característica en la realidad: una empresa de radio por Internet no identificada no implementa solo un algoritmo para seleccionar listas de reproducción de canciones, sino que hay 5 algoritmos maestros (cada uno utilizando diferentes lógicas internas) que se asignan a los oyentes en base a su perfil de comportamiento-escucha. Esto significa que los oyentes y los investigadores nunca pueden estar seguros de con cuál algoritmo han interactuado, así como de si su interacción individual con un algoritmo puede repetirse alguna vez. Tal incertidumbre asegura que cualquier conocimiento que se haya recogido con respecto al algoritmo "no se puede extrapolar de forma simple a todos los casos" (Kitchin 2017).

Conclusión

Los algoritmos no son intrínsecamente imposibles de entender, ni se puede pretender que sean los escudos de los desarrolladores de algoritmos por la plena responsabilidad de construir máquinas tan poderosas (Kroll 2018).

Reconocer los algoritmos como sistemas opacos, complejos y contingentes que a menudo desafían los métodos de investigación tradicionales no nos exime -como usuarios de Internet, investigadores y ciudadanos del siglo XXI- de nuestra responsabilidad de investigarlos y limitar sus efectos nocivos. Al contrario, debería estimularnos a seguir presionando.

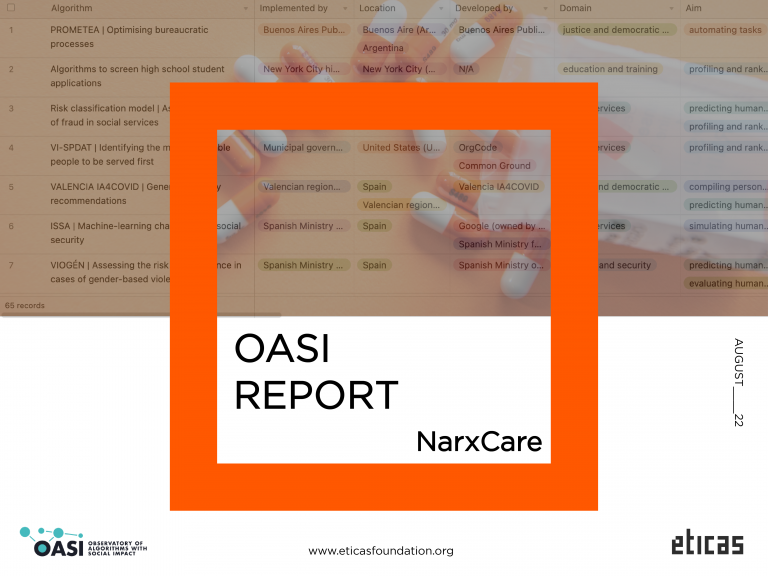

Mientras los algoritmos incrementan su rol en la toma de decisiones en nuestras vidas, Eticas Foundation está comprometida en hacer frente a los desafíos que implica su comprensión. A través de OASI (Observatorio de Algoritmos con Impacto Social), esperamos avanzar en su conocimiento público, mediante la creación de una base de datos que compila y clasifica historias reales de algoritmos y sus impactos humanos de alrededor del mundo. Podéis visitar el proyecto OASI aquí.

Bibliografía

Foote, B., & Yoder, J. (1997). Big Ball of Mud. Pattern Languages of Program Design, 4, 654–692.

Kitchin, R. (2017). Thinking critically about and researching algorithms. Information, Communication & Society, 20: http://mural.maynoothuniversity.ie/11591/1/Kitchin_Thinking_2017.pdf

Kroll, J. (2018). The fallacy of Inscrutability. Phil. Trans. R. Soc. A 376: 20180084

https://royalsocietypublishing.org/doi/10.1098/rsta.2018.0084

Lafrance, A. (2015). Not Even the People Who Write Algorithms Really Know How They Work. The Atlantic https://www.theatlantic.com/technology/archive/2015/09/not-even-the-people-who-write-algorithms-really-know-how-they-work/406099/

Seaver, N. (2014). Knowing algorithms. Media in Transition 8, MIT